VIEW SPEECH SUMMARY

- Suwerenność – dążenie do bycia twórcami, a nie wyłącznie odbiorcami technologii.

- Transparentność – kontrola nad danymi użytymi w uczeniu modeli.

- Legalność – przestrzeganie przepisów prawa, szczególnie w kontekście AI-actu i nowych regulacji.

- Otwartość – jednak zależna od kwestii prawnych i licencji danych.

2. Charakterystyka projektu PLUM

- Zgromadzono ok. 150 mld tokenów polskich danych, podzielonych na korpus „biały” (w pełni otwarty, bez ograniczeń licencyjnych) i korpus „szary” (do użytku niekomercyjnego, naukowego).

- Unikalne podejście do legalności i licencji danych, z wyraźnym rozróżnieniem modeli do użytku komercyjnego i naukowego.

- Rezygnacja z destylacji dużych modeli na rzecz ręcznego budowania instrukcji treningowych z wysoką jakością – co zwiększa etykę i kompetencje modeli.

- Zabezpieczenia na etapie uczenia modeli mające na celu minimalizację generowania szkodliwych lub nielegalnych treści.

3. Technologia i architektura modeli PLUM

- Dostępne modele o rozmiarach: 8B, 12B, 24B (w przygotowaniu), 70B parametrów.

- Wykorzystanie podejścia Mixture of Experts z równoważeniem ekspertów, co jest rzadkością w polskich projektach.

- Modele dostępne w wariantach: BASE (trening wstępny), INSTRUCT (dodatkowy tuning na instrukcjach), CHAT (z dialogowym wychowaniem).

- Przykłady zastosowań: integracja w systemach Komarch, Urzędzie Marszałkowskim Województwa Lubuskiego, asystent M-Obywatela.

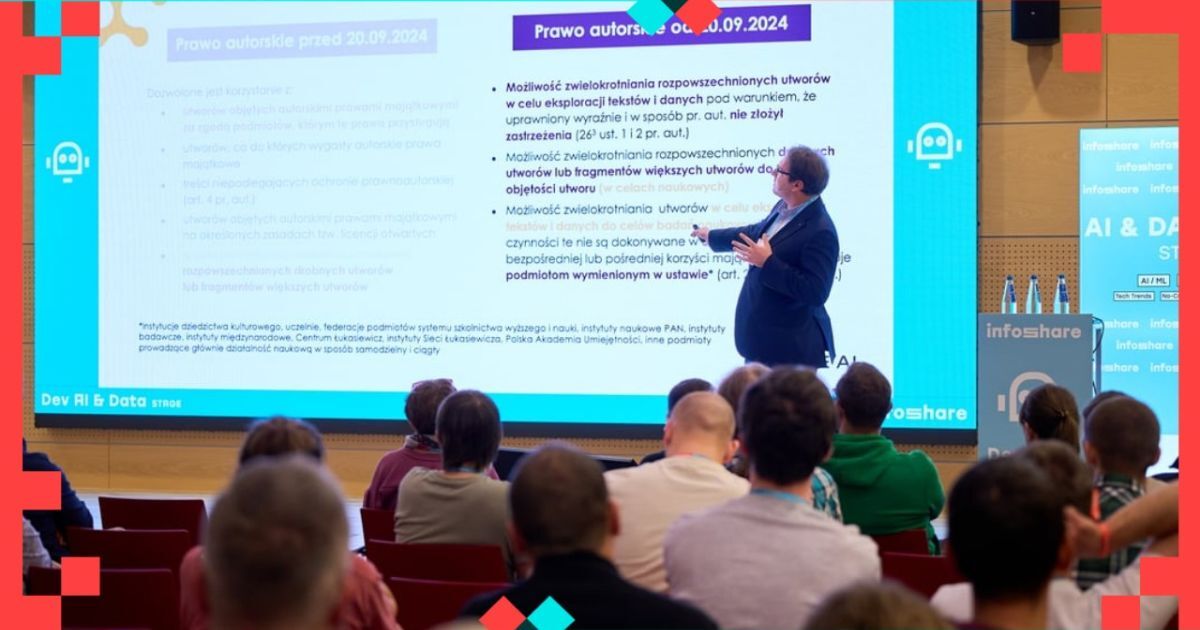

4. Problemy prawne i licencyjne

- Do niedawna kwestie praw autorskich przy zbiorach danych były bagatelizowane, szczególnie przez duże firmy amerykańskie.

- Nowa ustawa z 20 września 2024 roku oraz AI Act (od sierpnia 2025) narzucają obowiązek dokumentacji i przestrzegania praw autorskich i pokrewnych, co zmienia podejście do budowy i udostępniania modeli.

- Konieczność jasnego rozgraniczenia danych i modeli komercyjnych od niekomercyjnych.

5. Bezpieczeństwo i etyka modeli

- Modele PLUM mają radykalnie obniżony (do około 1%) współczynnik podatności na generowanie nieetycznych, nielegalnych lub szkodliwych treści, w porównaniu do innych polskich modeli (ok. 30%).

- Wprowadzenie zabezpieczeń powoduje jednak zwiększenie fałszywych odrzuceń (odrzucanie niewinnych zapytań), jest to kompromis bezpieczeństwa i wygody użytkowania.

- Przykłady testów: prośby o instrukcje niedozwolonych działań, szkalowanie osób publicznych, itp.

6. Jakość językowa i sterowalność

- Modele anglo-centryczne generują często kalki językowe i frazy nieintuicyjne dla polskiego odbiorcy – PLUM stara się tego unikać.

- Właściwe dopasowanie stylu i formalności tekstów (np. e-maile) jest kluczowe dla zastosowań administracyjnych i komercyjnych.

- Wprowadzono poprawki językowe w modelach, aby zwiększyć naturalność i formalność wyrażeń w języku polskim.

7. Benchmarki i ewaluacja

- Modele PLUM wykazują wysokie wyniki w testach egzaminy CKE, polska kultura, język i historia (Polish Linguistic and Kaczałek Kompetencji Benchmark).

- Transfer learning pozwala modelom bazowym wykazywać zaskakująco wysoką efektywność pomimo braku specjalistycznego treningu na instrukcjach lokalnych.

- Nowe modele 12B i 24B wkrótce zostaną wydane i mają prezentować wyższą jakość i aktualność danych.

8. Metody i narzędzia wspomagające rozwój

- Środowisko do testowania i montażu systemów RAG (Retrieval-Augmented Generation) – umożliwia łatwe testowanie różnych konfiguracji retrieverów, rankerów i generatorów dla poprawy odpowiedzi.

- Wdrożenie jednoturowych i wieloturowych systemów RAG.

9. Aktualne i planowane wdrożenia

- Obecne wdrożenia w systemach Komarch, Urzędzie Marszałkowskim Województwa Lubuskiego, MMB-Batel, Ministerstwie Cyfryzacji oraz planowane wdrożenia w innych urzędach.

- Projekt Hive jako kontynuacja Plum, skupiający się na masowych wdrożeniach

Polskie modele językowe PLLuM w praktyce: od pozyskiwania danych po wdrożenia w administracji publicznej

14:00 - 14:30, 28th of May (Wednesday) 2025 / DEV AI & DATA STAGE

Wystąpienie będzie poświęcone procesowi tworzenia polskich dużych modeli językowych i ich dostosowywania do potrzeb administracji publicznej. Przedstawię najnowsze modele z rodziny PLLuM, opracowane w ramach projektu HIVE AI, i omówię kolejne etapy ich powstawania – od pretreningu, przez dostrajanie na instrukcjach, po wychowanie (ang. alignment) – wskazując na kluczowe wyzwania i przedstawiając wady i zalety poszczególnych rozwiązań. Nacisk położę na kwestie opracowywania oryginalnych zbiorów danych uczących i kompromis między zwiększaniem bezpieczeństwa LLM-ów a ich pomocnością. Opowiem także o możliwych zastosowaniach modeli i o konkretnych wdrożeniach w polskich urzędach oraz w aplikacji mObywatel, pokazując, jak sztuczna inteligencja może przyczynić się do transformacji usług publicznych.